生成AI利用者の90%が未認識、リスクと情報漏洩の実態とは

生成AI利用者の90%が未認識、リスクと情報漏洩の実態とは

個人向けセキュリティサービスを提供するNordVPNが最近発表した調査結果によると、日本国内の生成AI利用者の9割近くが「AIに相談する際のリスク」を正しく理解していないことが明らかになりました。これは、生成AIが日々の生活に浸透している中で、私たちが気を付けるべき重要な問題を示しています。

調査背景

世界の生成AIユーザーは約8億人に達しています。具体的には、ChatGPTなどのツールを利用することで、プライバシーの保護や安全なデジタルライフについて相談する機会が増えています。しかし、NordVPNの調査では、多くのユーザーが無意識に個人情報を開示してしまっている現状が浮き彫りとなりました。この調査は、500人以上の日本人を対象に実施され、リスク認識のギャップと安全対策についての意識を探りました。

プライバシーリスクの理解

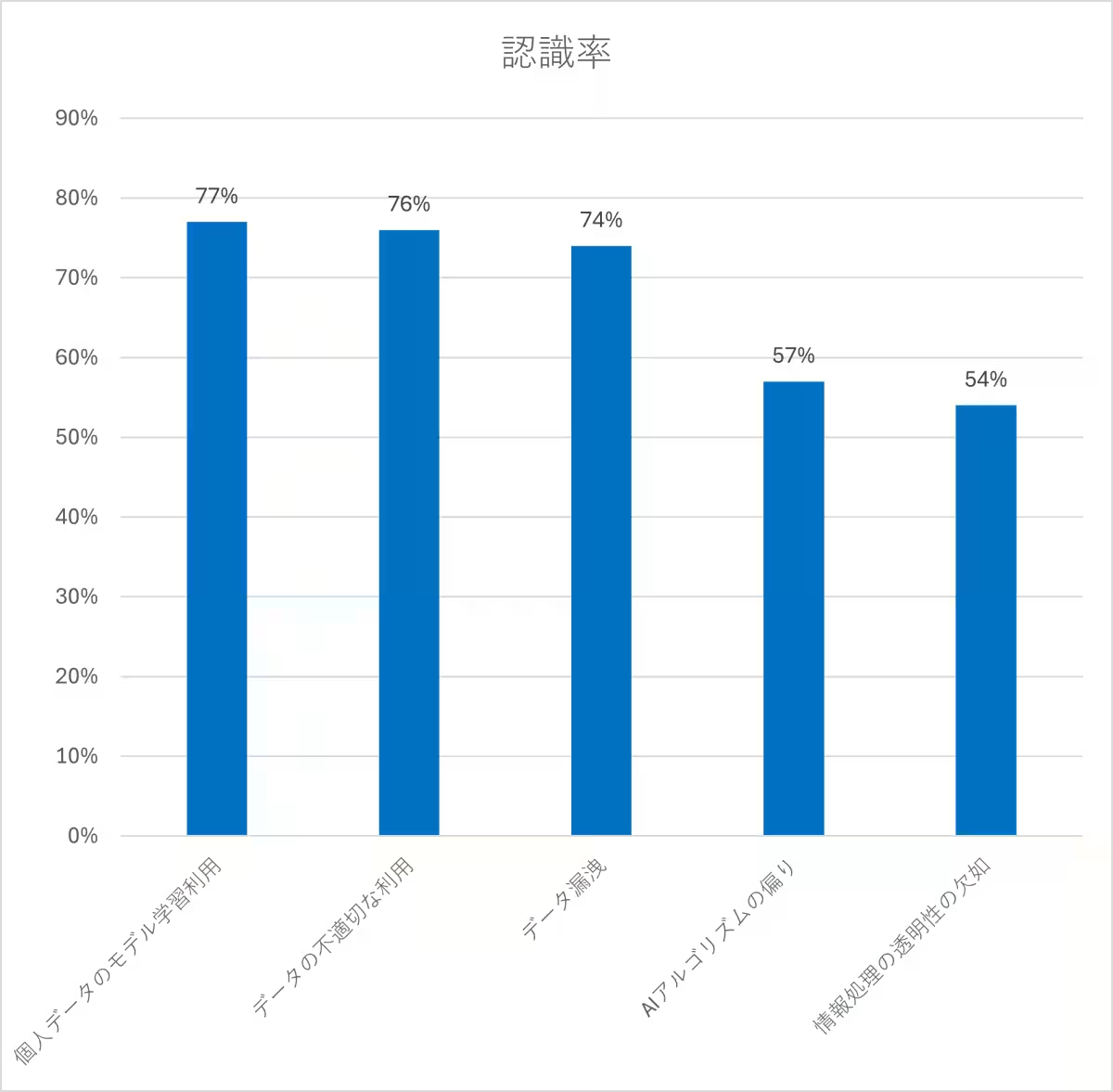

調査によると、「業務でAIを活用する際のプライバシーリスクを正しく理解している」と答えたのはわずか10%という衝撃的な結果が示されています。一方で、リスクの存在自体は認識されており、「個人データがAIの学習に利用されるリスク」「提供データの不適切な利用」などについてはそれぞれ77%と76%の人が理解しているとのことです。

しかし、こうしたリスクを認識しながらも、具体的にどのように対応すべきかについては明確な答えを持っていないのが実情です。リスク認識と行動の間にギャップがあることがわかります。

AIへの相談が引き起こす問題

生成AIが「デジタル生活の相談窓口」として利用される中で、ユーザーは実際に多くの個人情報をAIに提供しています。調査では、位置情報やSNSのプロフィール、また氏名や連絡先などが含まれ、特に意識せずに入力された情報がサイバー犯罪のリスクにつながる可能性が浮上しました。無害に思える質問でも、情報がログに残ると犯罪者による悪用を招く危険性があります。

SNSのアカウントに関する相談や金融情報の開示が無意識のうちに進んでいることも課題です。こうしたデジタル相談サービスの利用が、逆に情報漏洩のリスクを高める要因となっています。

実際に寄せられたセキュリティ質問

NordVPNによる調査の結果、一番多くの質問はフィッシング詐欺への対処方法や公共Wi-Fiの安全性に関するものでした。さらに、インターネットバンキングやパスワード管理についての相談も多く、生成AIが日常生活におけるセキュリティ対策に役立っている面も見受けられます。

これらの結果から、日本のユーザーがセキュリティ意識を持っていることが分かりますが、その一方で情報開示のリスクについての教育が不足していることが強調されます。

安全なAI利用のための3つの対策

NordVPNの最高技術責任者、マリユス・ブリエディス氏は、生成AIの安全な利用に向けた具体的な対策を提案しています。これらは、個人情報を含んだ質問をしないこと、AIツールの「学習利用オフ」設定を活用すること、VPNを使用して通信内容を暗号化することの3つです。

1. 個人情報を含んだままで質問しない:生成AIは外部サービスであり、入力された内容が学習や記録の対象となる場合があります。

2. AIツールの「学習利用オフ」設定を活用する:機密性の高い相談は避け、データが保存されないように設定を確認することが重要です。

3. VPNを活用して通信内容を暗号化する:公共Wi-Fiなどのリスクの高いネットワークでは、VPNを使用して通信を保護しましょう。

まとめ

AIは私たちの生活に大きな利便性をもたらす一方で、適切な利用意識が欠如していると新たなリスクを生む可能性があることが調査から浮き彫りになりました。今後は、AIとのやり取りにもプライバシー保護の意識を持って臨むことが求められます。安全なデジタルライフを送るために、NordVPNの提案を参考にしてみることをおすすめします。

トピックス(その他)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。