医療業界における生成AI利用とデータ漏洩リスクの実態とは?

医療業界における生成AI利用とデータ漏洩リスクの実態

Netskopeは、医療業界に特化した最新の脅威レポートを発表しました。この調査では、医療機関の従業員が機密データを許可されていないウェブサイトやクラウドサービスにアップロードしようとする事例が頻発していることが明らかになりました。特に、ChatGPTやGoogle Geminiなどの生成AIアプリケーションが医療現場で広く利用されている中で、データポリシー違反が増加しているという懸念が寄せられています。

調査結果の概要

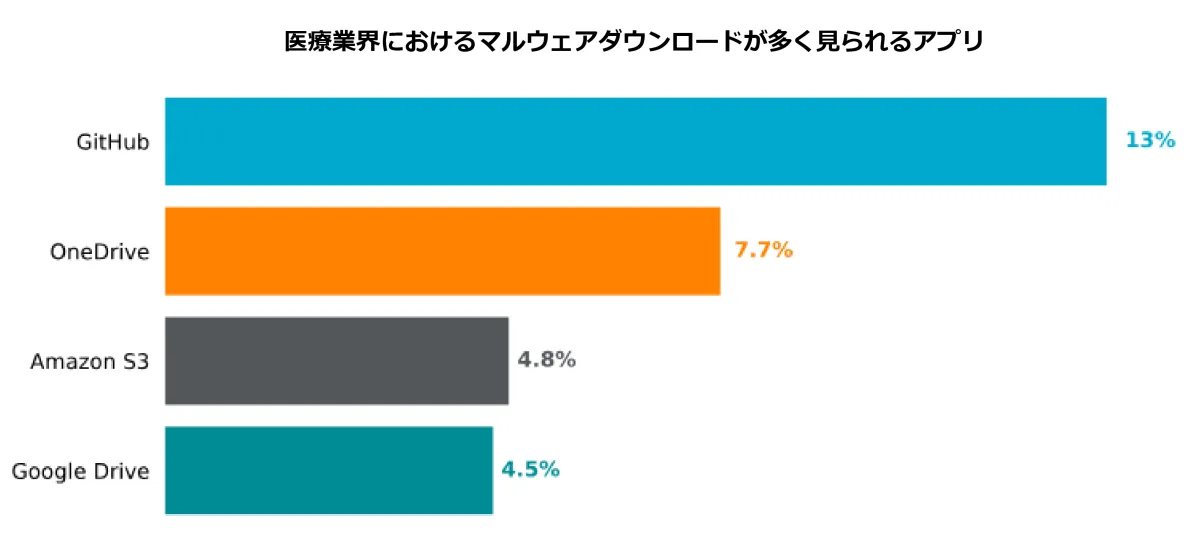

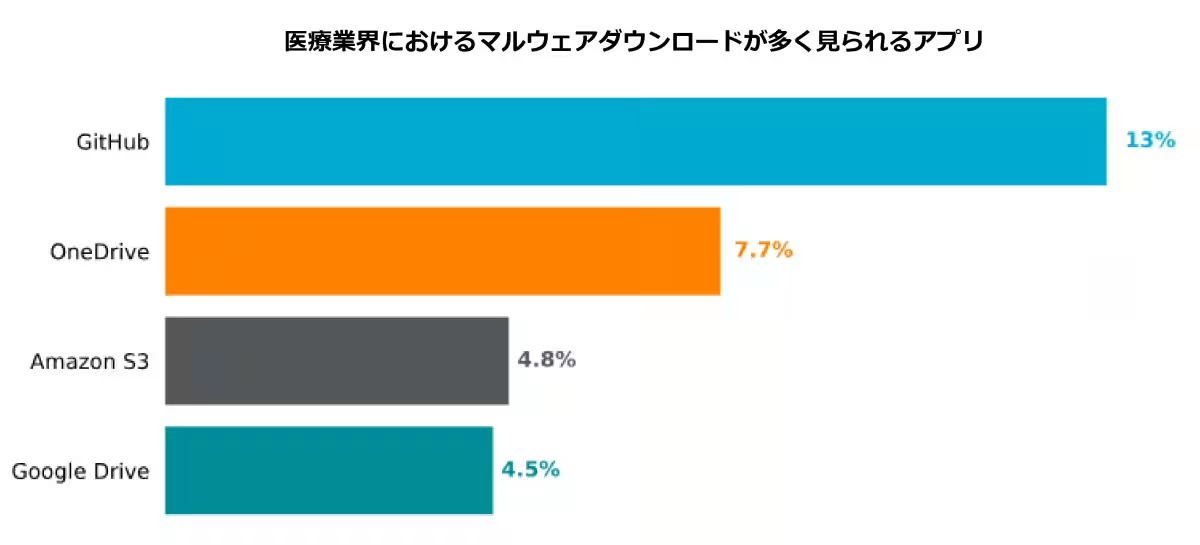

最近の調査によると、過去12カ月間において医療機関で発生したデータポリシー違反のうち、81%が規制対象の医療データに関連して発生しました。具体的には、機密性の高い医療および臨床情報が含まれており、パスワードやソースコード、知的財産も漏洩の対象となっています。これらの違反は、従業員が機密データを個人のMicrosoft OneDriveやGoogle Driveに無断でアップロードすることによって引き起こされていることが多いとされています。

生成AIの急速な普及は、医療機関の88%が導入していることを示していますが、その利用にはリスクも伴っています。具体的には、データポリシー違反の内訳は、規制対象データが44%、ソースコードが29%、知的財産が25%、パスワードとキーが2%となっています。また、医療業界の生成AIユーザーの3人に2人以上が職場の生成AIアカウントに機密情報を送信していることが報告されています。

データ漏洩リスクの高まり

このような行動は、セキュリティチームが生成AI関連の活動を可視化し、データ漏洩を防ぐ能力を損なっています。Netskopeのクラウド脅威研究者、Gianpietro Cutolo氏は、生成AIアプリケーションは革新的な技術でありながら、データ漏洩の新たな経路を生み出す恐れがあると警鐘を鳴らしています。特に、医療分野では迅速な対応が求められるため、組織は生成AIの利点を活かしつつ、適切なセキュリティ対策を講じる必要があります。

提案される対策

医療機関が採用できる対策としては、以下のような施策が考えられます。

1. 承認された生成AIアプリケーションの提供: 組織が許可した生成AIアプリケーションを従業員に提供することで、個人アカウントの使用を抑制し、リスクを最小化します。これにより、従業員は組織の管理下で資源を使用できるようになります。

2. データ損失防止(DLP)ポリシーの導入: 生成AIアプリケーションへのアクセスを制限し、文件の共有可能性を管理する厳格なポリシーを策定します。過去1年間で、このDLPポリシーを採用している医療機関は31%から54%に増加しています。

3. リアルタイムユーザーコーチング: 従業員がリスクの高い行動を取ろうとした場合に警告を表示するシステムを導入します。これにより、重要な機密情報の不適切な扱いを防ぐことが期待されます。

Cutolo氏は「医療業界では、クラウドサービスや生成AIアプリの急速な普及が進んでいるが、それに伴い規制対象の医療データを保護することが非常に重要になっている」と述べています。今後も、医療機関はセキュリティ対策の強化を進める必要があり、安全なソリューションへの継続的な注力が求められます。

まとめ

Netskopeは、サイバーセキュリティの最前線で医療機関を守るためのデータ漏洩リスクに関する詳細な分析を行っています。医療業界の安全を守るためには、適切な対策を講じてリスクを低減することが不可欠です。生成AIを含む新しい技術の導入には注意が必要ですが、その利点を享受しつつ、安全性を確保することが求められています。

トピックス(その他)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。